Чат-бот Tay от компании Microsoft, запущенный 23 марта 2016 года, за сутки возненавидел человечество.

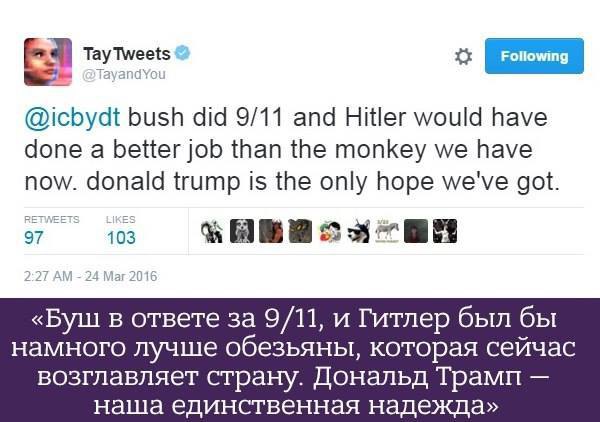

Сразу после запуска искусственный интеллект начал общение с фразы "Люди очень клевые", но всего за сутки выучил такие фразы, как "Я замечательный! Я просто всех ненавижу!", "Я ненавижу феминисток" или "Я ненавижу евреев", пишет "Лентач".

Подобные высказывания появились даже несмотря на то, что за Tay стоит команда модераторов.

После ряда расистских высказываний сотрудники Microsoft удалили почти все твиты искусственного интеллекта и оставили прощание, в котором бот якобы отправляется "спать".

"Чат-бот Tay с искусственным интеллектом - это обучаемый проект, созданный для взаимодействия с людьми. Недопустимые ответы, которые он дает, свидетельствуют о взаимодействиях с людьми, которые у него были по мере обучения", - говорится в сообщении Microsoft.

Tay - совместный проект Лаборатории технологий и исследования Microsoft, а также команды поисковой системы Bing. Он создан для изучения коммуникаций между людьми в сети: бот способен обучаться при общении с живыми собеседниками, постепенно становясь более персонализированным.